Wie baut man ein sicheres und skalierbares System zur Erkennung von Anomalien auf? – Teil 1

Ich habe unseren Experten Wiktor Franus über das Modul Big Data (ein Teil von Smart RDM) befragt. Es war ein spannendes Gespräch, in dem immer neue Fragen aufkamen. Daraus entstand dieser Text.

Wie man ein sicheres und skalierbares System zur Erkennung von Anomalien aufbaut – eine einfache Antwort, die gar nicht so einfach ist.

Für mich ist das Thema der Anomalieerkennung neu. Jeden Tag entdecke ich neue Möglichkeiten, die die Datenanalyse bietet. Das Themengebiet ist so groß, dass ich noch einen weiten Weg vor mir habe. Dank der Spezialisten, mit denen ich zusammenarbeite, konnte ich schon viel erkunden. Nun habe ich beschlossen, das Gelernte mit anderen zu teilen.

Beginnen wir mit dem, was man braucht, um Daten schnell, effizient und adäquat zu analysieren: Das sind zum einen das richtige Know-how und zum anderen die entsprechenden Werkzeuge. In diesem Artikel geht es um das umfassende Know-how.

Know-how – welches Wissen benötige ich für das Modul Big Data

Ich schreibe hier keinen wissenschaftlichen Artikel über Datenanalyse oder über geniale Fähigkeiten, sondern über praktisches Wissen und Kenntnisse, die unsere Experten bei der Lösung der Probleme unsere Kunden benötigen.

Branchenkenntnisse sind für einen effektiven Algorithmusentwurf von entscheidender Bedeutung. Sie ermöglichen unseren Experten, die Beziehungen zwischen verschiedenen Faktoren zu verstehen. Denn das Datenmodell muss so angepasst werden, dass alle Elemente, die das Analyseergebnis beeinflussen, berücksichtigt werden. Der Grad der Genauigkeit und Nützlichkeit der Informationen hängt weitgehend von den Fachkenntnissen der Personen ab, die die Algorithmen entwickelt haben. Natürlich ist es möglich, bekannte und häufig verwendete Lösungen anzuwenden, z. B. Three Sigma. Die zu erwartenden Abweichungen werden sich aber bei den Ergebnissen stark von denen unterscheiden, die bei Smart RDM mit dem Big Data-Modul erzielt werden.

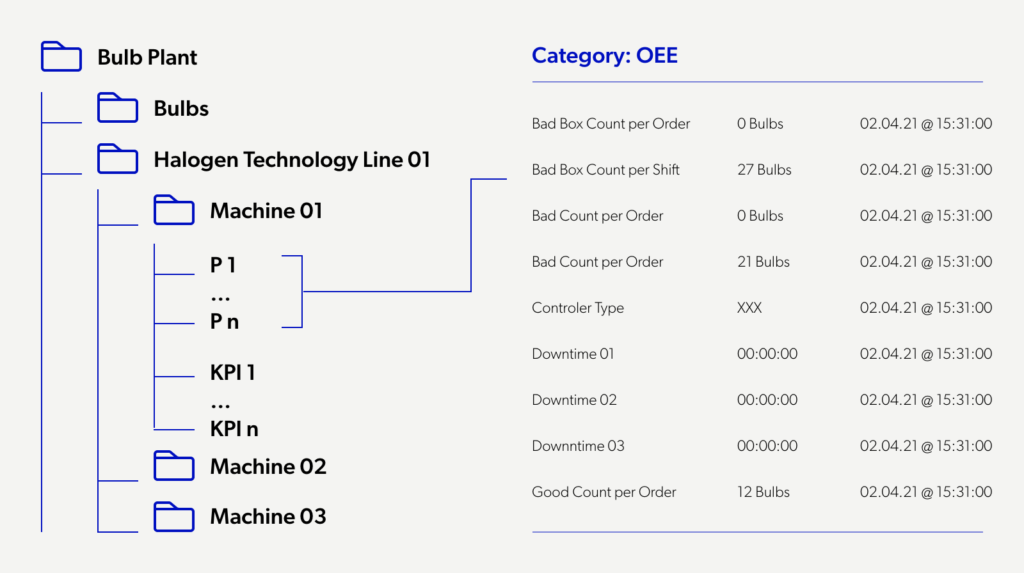

Das Know-how, wie man den Prozess effektiv durchführt, ist auch das Ergebnis von Erfahrungen aus vielen Projekten, Versuchen, Misserfolgen und Erfolgen – vor allem der richtigen Datenzuordnung. Um nützliche Analyseergebnisse zu liefern, müssen wir wissen, was wir analysieren und warum. Aus diesem Grund erstellen wir zunächst ein Modell für jedes Objekt, das wir überwachen wollen. Die Daten werden dann angemessen strukturiert. So können wir ihre Quelle lokalisieren, angefangen von einer übergeordneten Ebene (Stadt, Fabrik, Halle, Maschine, Turbine, Umspannwerk) bis hin zu einer einzelnen Komponente.

Das Know-how über den genauen Hintergrund der Datenanalyse ist eine wichtige Voraussetzung. Wir betrachten die Analyse unter zwei Aspekten, nämlich der Überwachung langfristiger Beziehungen und der Erkennung einzelner Ereignisse (z. B. Ausfälle).

Die Überwachung von Beziehungen umfasst die Verfolgung von Veränderungen im Zeitverlauf, von Trends und die Erkennung von langfristigen Anomalien in Daten. Um zeitliche Veränderungen zu überwachen und zu analysieren, müssen wir Daten von dem jeweiligen Objekt (Gerät, Maschine usw.) in Form einer Zeitreihe sammeln, archivieren und verarbeiten. Das bedeutet die Daten werden mit Zeitstempeln wie Datum und Uhrzeit gespeichert. Zusätzlich speichern wir statische Daten. Diese konstanten Parameter ändern sich nicht oder nur sehr selten. Dabei kann es sich zum Beispiel um Elemente von Geräteeigenschaften handeln, die unsere Modelle parametrisieren. Über die Erkennung von Einzelereignissen werde ich später schreiben, denn ein weiterer Aspekt ist dafür wichtig.

Wir wissen, wie wir in kürzester Zeit Ergebnisse mit gut nutzbaren Informationen liefern können. Wir speichern alle Messwerte in einem zentralen Repository. Dieses ermöglicht uns, eine verlustfreie Historie zu erstellen und in einem großen Zeitbereich zu recherchieren. Auf diese Weise erhalten wir Zugang zu einer enormen Menge an Daten. Dies ist sowohl ein Vorteil als auch eine Gefahr für die Effizienz des Analyseprozesses.

Unsere Experten haben ein Modell entwickelt, das die optimale Nutzung solcher umfangreicher Datensätze gewährleistet. Die Daten werden in einer aggregierten Form aus dem Repository entnommen (z. B. Durchschnittswerte, Mediane oder stündliche oder tägliche Extremwerte). Diese werden so ausgewählt, dass sie den wirtschaftlichen Anforderungen der Lösung entsprechen. Auf diese Weise wird die Menge der heruntergeladenen Daten und folglich der Verbrauch von Server- oder Cloud-Ressourcen für die Durchführung von Analysen optimiert. Anschließend überprüfen wir die Daten auf fehlerhafte Werte. Dabei überprüfen wir die Daten zunächst auf Anomalien und filtern diese im nächsten Schritt heraus. Es ist wichtig zu wissen, dass Anomalien aus unserer Sicht Daten sind, die entweder bestimmte statistische Werte überschreiten oder Daten, die gänzlich fehlen.

Um zuverlässige Analyseergebnisse zu erhalten, wird das Know-how, wie man mit Daten arbeitet, benötigt. Bei der Aufbereitung der Daten für die Analyse werden zusätzliche „Lücken“ geschaffen. Dazu werden Daten, die von der Norm abweichen, entfernt. Danach werden die Datenreihen durch lineare Interpolation* vervollständigt. Durch dieses Verfahren werden bereinigte Daten erzeugt, die im Repository gespeichert werden.

Warum lineare Interpolation? Aus Gründen der Effizienz und der Qualität der Ergebnisse. Bei der Arbeit in großem Maßstab, bei der Tausende oder Hunderttausende von Komponenten der Infrastruktur des Kunden gleichzeitig analysiert werden, ist die Effizienz der Lösung von entscheidender Bedeutung. Das System muss in kürzester Zeit Informationen liefern. Zu komplexe Lösungen würden den Prozess in die Länge ziehen, ohne die Qualität der Ergebnisse wesentlich zu verbessern.

Wir nutzen Branchenkenntnisse bei der Erkennung von Anomalien durch Algorithmen auf der Grundlage von Datenabhängigkeiten, Abweichungen von theoretischen Werten (z. B. Heizkurve, Leistungskurve) und bei der entsprechenden Kategorisierung von Anomalien. So können z.B. bei Fernwärme-Unterstationen große Durchflussschwankungen in einem kurzen Zeitraum ein Hinweis auf falsch eingestellte Regelparameter sein. Bei Windkraftanlagen können mögliche Schäden eine Abweichung der tatsächlichen Leistung von der theoretischen erzeugen.

An dieser Stelle möchte ich auf die Überwachung und Analyse von Ereignissen zurückkommen. Dies ist ein separater Prozess. Ein Beispiel ist die Fehlererkennung, bei der wir mit einer Reihe von Daten arbeiten, ohne sie zu aggregieren oder zu mitteln. Da wir auf der Ebene des Repository arbeiten, brauchen wir für diesen Prozess keine zusätzlichen Ressourcen.

Ich werde hier stoppen. Doch das ist noch nicht das Ende der Geschichte. Im zweiten Teil des Artikels beschreibe ich die Werkzeuge des Big-Data-Moduls und den Prozess der Durchführung der Analyse.

Wie wir dieses Wissen für unsere Kunden einsetzen, können Sie in anderen Blogartikeln, Fallstudien, und unter www.smartrdm.com nachlesen.

Interview geführt von: Jakub Ładyński

Lineare Interpolation – eine Methode zur Ermittlung von Näherungswerten einer Funktion in einem bestimmten Intervall, indem die Punkte an den Enden des Intervalls durch eine gerade Linie verbunden werden.